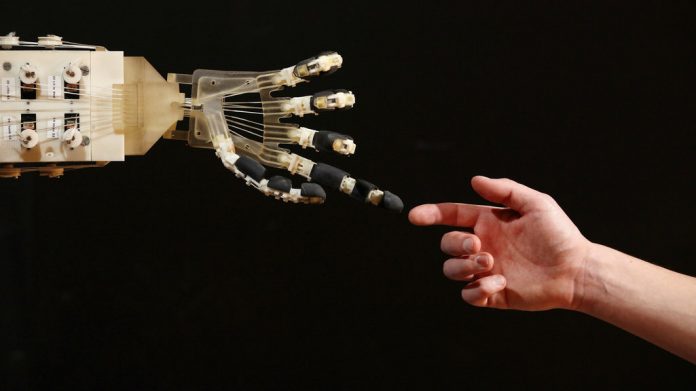

Yapay zekanın geleceği hakkında pek çok gelişme ve öngörü bulunmakta. Bu yenilikçi yaklaşımın hastalıkları nasıl iyileştirilebileceği, teknolojik gelişmeleri insanın faydasına olacak şekilde nasıl hızlandırabileceği ve insanı nasıl daha iyi bir konuma getireceği konusunda pek çok sansasyonel haber yayınlanıyor. Sadece medya başlıklarına baktığımızda dahi yapay zekanın toplumun her kesimine sızmış olduğu bir zamanda yaşıyor olduğumuzu düşünebiliriz.

Yapay zekanın gelecek vaat eden fırsatlar yarattığı yadsınamaz gerçek bir olsa da, bu durum “yapay zeka çözümcülüğü” olarak tanımlanabilecek bir zihniyetin ortaya çıkmasına neden olmuştur. Bu felsefe, yeterli veri sağlandığı takdirde makinelere öğretilen bir takım algoritmalarla tüm insanlığın sorunlarının çözülebileceğini iddia eden bir felsefedir.

Fakat bu düşüncede yanlış olan birşey var. Yapay zekanın ilerlemesini desteklemek yerine, önemli güvenlik ilkelerini göz ardı ederek ve yapay zekanın insanlık için gerçekten neler yapabileceğine dair gerçekçi olmayan beklentiler içine girmek, yapay zekanın değerini tehlikeye atmaktadır.

Yapay Zeka Çözümcülüğü

Yapay zeka çözümcülüğünün Silikon Vadisi’ndeki teknoloji uzmanları ağzından, dünyanın dört bir yanındaki devlet memurları ve politikacıların zihnine kadar ulaşması sadece birkaç yıl sürdü. Sürekli değişen bu teknoloji, yapay zekanın insanlığı yok edeceği inancını öne süren karşı ütopyayı, algoritmik bir kurtarıcımızın var olduğu ütopyacı bir inanca çevirdi.

Artık hükümetlerin ulusal yapay zeka çalışmalarına destek verdiklerini görüyoruz ve gelişmekte olan makine öğrenim sektörüne hükmetmek için teknolojik ve etkili bir silahlanma yarışında rekabet ediyoruz. Örneğin, İngiltere hükümeti, kendisini bu alanda lider olarak konumlandırmak için yapay zeka araştırmalarına 300 milyon sterlin yatırım yapacağına söz verdi.

Yapay zekanın dönüştürücü potansiyeline hayran olan Fransız devlet başkanı Emmanuel Macron, Fransa’yı küresel bir yapay zeka merkezine dönüştürmeyi taahhüt etti.

Bu arada, Çin hükümeti ulusal bir plan ile 2030 yılında 150 milyar dolar değerinde Çinli bir yapay zeka endüstrisi oluşturmak için yapay zeka konusundaki maharetlerini artırma yolunda.

Nöral Ağlar – Söylemesi Dile Kolay

Dünyadaki birçok siyasal parti yaklaşımı, gözümüzde büyütülen “yapay zeka devrimi” nin olası etkilerinin çığırtkanlığını yapsa da, gerçek dünyada gelişmiş makine öğrenimi sistemlerinin konuşlandırılması konusundaki karmaşıklığı hafife almaktadırlar.

Yapay zeka teknolojilerinin en umut verici çeşitlerinden biri ise nöral ağlardır. Bu makine öğrenim biçimi, insan beyninin nöronal yapısından sonra, varolan en küçük ölçekteki modellemedir. Birçok yapay zeka tabanlı ürün, büyük hacimli verilerden kalıplar ve kurallar çıkarmak için bu yapay nöral ağları kullanır. Fakat pek çok politikacının anlayamadığı şey, bir soruna sadece yapay bir nöral ağ eklemekle, o sorunun otomatik olarak çözülemeyeceğidir.

Veri Bürokrasisine Meydan Okumak

Yapay zeka sistemlerinin çalışabilmesi için çok fazla veriye ihtiyaç vardır. Ancak kamu sektörü gelişmiş makine öğrenimini desteklemek için uygun veri altyapısına sahip değildir. Verilerin çoğu çevrimdışı arşivlerde saklanır. Mevcut olan birkaç sayısal veri kaynağı ise bürokrasiye gömülmüş durumdadır. Bu sayısal veriler de her biri özel izinlere ihtiyaç duyulan farklı devlet dairelerinde tutulmaktadır. Her şeyden önce, kamu sektörü makine zekasının faydalarından tam olarak yararlanmak için ihtiyacı olan doğru teknolojik imkanlardan yoksundur.

Tüm bu nedenlerden dolayı, yapay zeka merakı birçok eleştirinin hedefi olmuş durumda. Berkeley’de bilgisayar bilimleri profesörü olan Stuart Russell, üstün zekalı robotların insanlığı ele geçirmesi varsayımı yerine, yapay zekanın basit günlük uygulamalara odaklanan daha gerçekçi bir yaklaşımı olması gerektiğini savunuyor. Benzer şekilde, MIT’nin robotik bilimler profesörü olan Rodney Brooks, “robot ve yapay zeka konusundaki hemen hemen tüm yeniliklerin, alan içi ve alan dışındaki insanlar tarafından, gerçekte olduğundan çok daha alakasız olarak hayal edildiğini” söylüyor.

Makine öğrenimi sistemlerinin uygulaması konusundaki pek çok zorluktan biri de, yapay zekanın karşı saldırılara karşı aşırı derecede hassas olmasıdır. Yani bunun anlamı, kötü amaçlı bir yapay zekanın başka bir yapay zekayı hedefleyerek, yanlış tahminler yapmasına veya belirli bir şekilde davranmasına zorlayabilecek olmasıdır. Pek çok araştırmacı uygun güvenlik standartları ve savunma mekanizmaları olmaksızın, yapay zekanın yayılmasına karşı ciddi uyarılarda bulundu. Yine de, yapay zekanın güvenliği genellikle göz ardı edilen bir konu olmaya devam ediyor.

Makine Öğrenimi Hayal Değil

Eğer fayda elde edip yapay zekanın potansiyel zararlarını da en aza indirebilirsek, makine öğreniminin hükümet, iş dünyası ve toplumun belirli alanlarında işe yarar bir şekilde nasıl uygulanabileceğini düşünmeye başlamalıyız. Bu da, yapay zeka etiği ve bir çok insanın makine öğrenimine yönelik güvensizliği hakkında karşılıklı bir fikir alışverişi yapmamız gerektiği anlamına gelir.

En önemlisi, yapay zekanın sınırlarının farkında olmamız ve hangi durumlarda insanların kontrolü elden bırakmamaları gerektiğine dikkat etmemiz gerekiyor. Yapay zekânın abartılı bir resmini çizmek yerine, bir adım geri gelip büyük resme uzaktan bakarak yapay zekanın gerçek teknolojik yeteneklerini hayal ürünü olanlardan ayırmak önemlidir.

Uzun zamandır, Facebook yalan haberlerin yayılması ve nefret söylemleri gibi sorunların algoritmik olarak tanımlanıp durdurulabileceğine inanıyordu. Ancak, parlamenterlerin baskısı altında bulunan şirket, kullanmakta olduğu algoritmalarını 10.000’den fazla insandan oluşan bir yorumcu ordusuyla değiştirmeyi taahhüt etti.

Tıp dünyası da yapay zekanın tüm problemler için bir çözüm olarak kabul edilemeyeceğini ifade ediyor. IBM Watson for Oncology, doktorların kanseri tedavi etmeleri için kullanılması amaçlanan bir yapay zeka programıydı. En iyi önerileri sunmak için geliştirilmiş olmasına rağmen, uzmanlar bir makineye güvenmeyi doğru bulmuyordu. Sonuç olarak bu yapay zeka ürününü deneyen çoğu hastene, programı kullanmayı bıraktı.

ABD mahkemelerinde suçluları cezalandırmak için yasal alanda algoritmaların kullanılması sonucu benzer sorunlar ortaya çıktı. Bir algoritma, risk değerlendirme puanlarını hesapladı ve hüküm verme konusunda yargıçlara tavsiyede bulundu. Sistemin yapısal ırk ayrımcılığını arttırdığı ortaya çıkınca bu yöntem terk edildi.

Bu örnekler, her şey için bir yapay zeka çözümünün olmadığını göstermektedir. yapay zekayı her alanda kullanmak her zaman verimli ve yararlı olmayabilir. Her problem mekanik zekayla çözülemez. Söz konusu tecrübeler, ulusal yapay zeka programlarına yaptıkları yatırımları artırmayı hedefleyen herkes için önemli bir derstir: Tüm çözümler maliyete tabidir ve herşey otomatikleştirilemez.

Kaynak: Science Alert